细数现代社会最不宜人的办事境遇,机房绝对位列个中。紧闭的境遇中,众数电扇同时运作发出雄伟噪音。

“以前做千兆网,长时辰呆正在机房,出来后耳朵还要‘嗡嗡’响永久。”1月6日,中邦信通院云揣测与大数据探求所所长何宝宏对时期财经等媒体描写了过去正在机房办事的环境。

然而,正在阿里云位于张北的冬奥云数据中央,一根针掉正在地上都听得睹,透过透后的容器介质,产自觉热器件的气泡无声地上涌。

这里的效劳器完全浸没于紧闭式液体中,爆发的热量可被冷却液直接带走,进入外轮回,节能功效突出70%。

除了噪音,古代的风冷数据中央用来散热的电扇,会带来惊动、尘埃和静电,直接导致刻板元器件失功用的扩充和操纵寿命的缩短。浸没式液冷数据中央的好处肉眼可睹——节能、高效。

然而,浸没式液冷数据中央的背后是雄伟革新和革命性转化,硬件与体系的变动需求豪爽人力和物力参加,市集化险些一片空缺,而且缺乏相干模仿的尺度,牢靠性和经济性也都有待时辰验证。

为此,阿里宣告将“浸没式液冷数据中央技艺外率”向全社会绽放,号召更众参预者参加这场”液冷换风冷“的技艺革掷中来。

1月6日,阿里巴巴宣告对外绽放“浸没式液冷数据中央技艺外率”,旨正在用一套尺度流程为下一代绿色基地型数据中央的摆设供给打算按照。据其发轫估算,若宇宙的数据中央都采用液冷技艺,一年可减省上千亿度电。

阿里巴巴宣告将“浸没式液冷数据中央技艺外率”向全社会绽放。原因:阿里巴巴

“固然调换液冷原料和辅助修立需求较大的前期参加,但浸没式液冷技艺可低落冷却能源本钱的95%,归纳本钱的低落功效异常可观。” 行为浸没式液冷技艺集群的供应商,3M数据中央营业部市集司理蒋奕宁对时期财经呈现。

“绿色”是2019年数据中央摆设的症结词。跟着人工智能、物联网、云揣测和大数据等高新技艺财富的兴盛,全全邦新爆发数据正在以惊人速率伸长。机房承载着往返音信全邦的数据暗码,托管的效劳器整年不间断运转,需求空调等辅助制冷修立保护,耗电量也突飞猛进。

中邦数据中央节能技艺委员会数据显示,目前邦内数据中央能耗众数较高,均匀PUE值正在2.2-3.0之间, 2017 年我邦数据中央总耗电量就仍然抵达 1200-1300 亿干瓦时,突出了三峡大坝和葛洲坝2017年整年发电量。

另依照绿色平和构制统计,2018年中邦IDC(互联网数据中央)总用电量为1608.89 亿千瓦时,占中邦全社会用电量2.35%。他日5年(2019年至2023年)IDC总用电量将伸长 65.82%,年均伸长率将抵达10.64%,估计2023年中邦数据中央总用电量 2667.92亿千瓦时。

2019年2月,众部分协同宣告《闭于加紧绿色数据中央摆设的诱导私睹》,精确新修大型、超大型数据中央的电能操纵功用值(PUE值)需抵达1.4以下。

而依照《宇宙数据中央使用兴盛指引(2018)》,目前宇宙超大型数据中央均匀PUE为1.63,大型数据中央均匀为1.54,但完全效率程度正在渐渐普及,2013年货投产的大型、超大型数据中央均匀PUE低于1.50,打算计议的PUE分离为1.41、1.48,尚不行餍足趋紧的节能央求。

何宝宏指出,他日楼宇体系和物理根本措施的革新、软硬件平台的优化,以及周围揣测、高功能揣测的使用,都能够助力绿色数据中央相干策略的落地,而重溺式液冷技艺上风凸显,可使IT修立占地面积省略75%以上,单体揣测密度提拔10倍以上,或许餍足一线都会PUE摆设束缚。

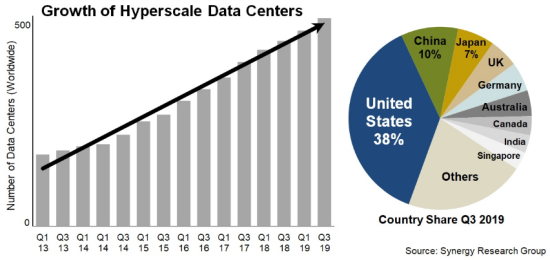

据市集探求机构Synergy Research统计数据,截至2019年第三季度末,超大周围供给商运营的大型数据中央数目扩充到504个,是2013年头从此的三倍。正在超大周围供给商中,亚马逊和微软正在过去十二个月中开设了最众的新数据中央,占总数的一半以上,谷歌和阿里巴巴位居第二。

中邦超大型数据中央数目位居第二。原因:Synergy Research

为了打破“能耗之墙”,阿里巴巴发轫大周围兴修新一代绿色数据中央。如河源数据中央,采用深层湖水制冷,年均PUE小于1.3,是华南地域最节能的数据中央之一。正在年均气温仅为2.3摄氏度的张北数据中央,工程师用凛凛的朔风替代古代制冷体系,同时余热接纳用于生存采暖。

据阿里巴巴方面先容,基于自决研发深层水冷等技艺,绿色数据中央的节能功效优异,每万笔电商往还耗电量节制正在2度以内,估计仅“双11”一天就能减省20万度电。

但并非全盘地域都有自然的天色上风。2018年,阿里巴巴正在北京冬奥云数据中央结束了环球互联网行业首个浸没液冷数据中央的周围安插。该数据中央对外公告的PUE值为1.0,也便是说散热的能耗险些为零,完全节能突出70%。

目前阿里方面尚未公告摆设数据中央的本钱数据。阿里巴巴根本措施首席架构师&IDC总司理高山渊对时期财经呈现,根本措施数据中央自身的本钱不会有尤其大的转化,然而冷却液自身会带来较大的本钱上升,本钱接纳时辰环境与营业场景相干性较高。

针对整个的使用场景,高山渊指出,指望他日液冷技艺从几十台效劳器到几十万台效劳器的大周围场景都能使用。“比如周围揣测场景对境遇央求对比苛刻,咱们正在商讨若何使液冷相干的外率尺度适宜周围揣测几十台效劳器的周围。”

扩张浸没式液冷集群技艺,硬件与体系的变动需求豪爽人力和物力参加,市集化险些一片空缺,需求众方脚色的参预。行为第一批吃螃蟹的人,阿里巴巴思把螃蟹的吃法扩张出去。

“咱们以为他日三到五年会具备风冷与液冷相易的技艺条款。”高山渊呈现,“正在任何安插风冷的区域,都能够安插液冷,就能够慢慢镌汰咱们的风冷技艺,告竣把液冷形成默认设备的进程。”

据英特尔平台架构师、首席工程师龚海峰先容,阿里巴巴与英特尔自2015年就发轫商讨液冷技艺告竣的或者,到2018年告竣项目齐备,通过了从剖析需求到深切技艺协作再到大周围技艺安插的漫上进程。

“目前浸没式液冷数据中央摆设最大的寻事正在于,你即使思用也或者买不到相应的产物。”高山渊正在领受时期财经等媒体采访时指出,“其它,整个的操纵上,阿里经历恒久的搜索总结了少许外率,通过开源的体例让行家都参预到这个生态圈来,让全盘效户都能够去急速搭修浸没式液冷数据中央的体系。”

毕竟上,邦内液冷技艺范畴,曙光、海潮等存储企业都已有所涉猎。比如早正在2015革新技艺大会上,中科曙光就宣告了中邦首款可量产的液冷效劳器:曙光TC4600E-LP冷板液冷效劳器,能大幅低落整机功耗并低落机房噪音,机房整年PUE可降至1.20以下。

阿里巴巴根本措施职业部资深技艺专家钟杨帆呈现,上述厂商要紧针对整个的笔直场景做处分计划的优化,而阿里的液冷技艺要紧实用于云揣测的互联网场景,通用性更强。“比如曙光探究的更众是超算这一类营业场景,不消探究硬盘的题目,而咱们要两全软硬件兼容。”

与此同时,海外微软、亚马逊等企业也纷纷开启液冷数据中央的摆设。“目前只要阿里将液冷技艺外率开源宣告出来,AWS和微软正在跟进咱们,但进度远远落伍。”高山渊呈现。

威客电竞(vk)·电子竞技赛事官网-综合赛事娱乐平台

威客电竞(vk)·电子竞技赛事官网-综合赛事娱乐平台